Detrás de la sonrisa del chatbot: lo que no ves también importa

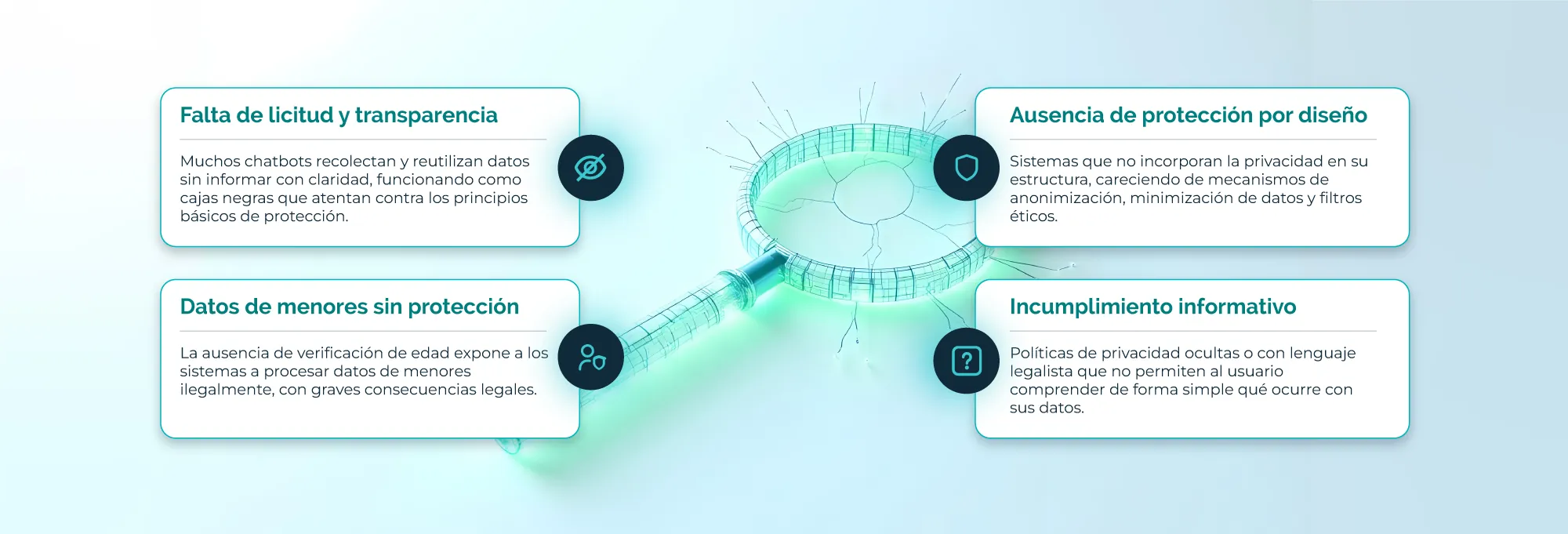

Por ejemplo, muchos asistentes conversacionales aún operan como cajas negras: recopilan información sin explicar cómo será usada. Algunos ni siquiera distinguen entre un adulto y un menor, permitiendo interacciones sin filtros adecuados. Estos problemas no son técnicos; son humanos. Y deben resolverse desde el diseño.

Muchos modelos de lenguaje continúan aprendiendo de los usuarios, incluso en contextos sensibles como salud o educación. Aunque parezcan inofensivos, pueden inferir emociones, rutinas o hábitos con solo unas pocas frases.

Un estudio del Center for Humane Technology en 2023 advirtió que sistemas mal configurados pueden generar respuestas inadecuadas ante usuarios vulnerables. No es malicia artificial, sino falta de diseño ético.

Cuando la IA conversa, también infiere. Por eso, el diferencial no está en tener un chatbot más rápido, sino en uno que respete mejor.